近日,机械与电子工程学院田富洋副教授团队在期刊《Computers and Electronics in Agriculture》在线发表了题为“An efficient multi-task convolutional neural network for dairy farm object detection and segmentation”的研究论文。田富洋副教授为该论文的第一作者,王中华教授和于镇伟副教授为该论文的通讯作者。

自走式牛场推料机器人具有推料及时、劳动强度低、节约饲料等优点,是实现智能化、数字化养殖的关键装备。自走式推料机器人将广泛的应用于奶牛养殖中。作业时,自走式推料机器人需要在复杂多变的牛场环境中检测出不同类型和尺寸的目标,如奶牛、人员、车辆、栅栏等。根据检测的不同目标采取相应行动,如避让、停止、警告等。这些作业任务对检测算法的精度和速度都有较高的要求,而现有的目标检测算法难以同时满足这些要求。

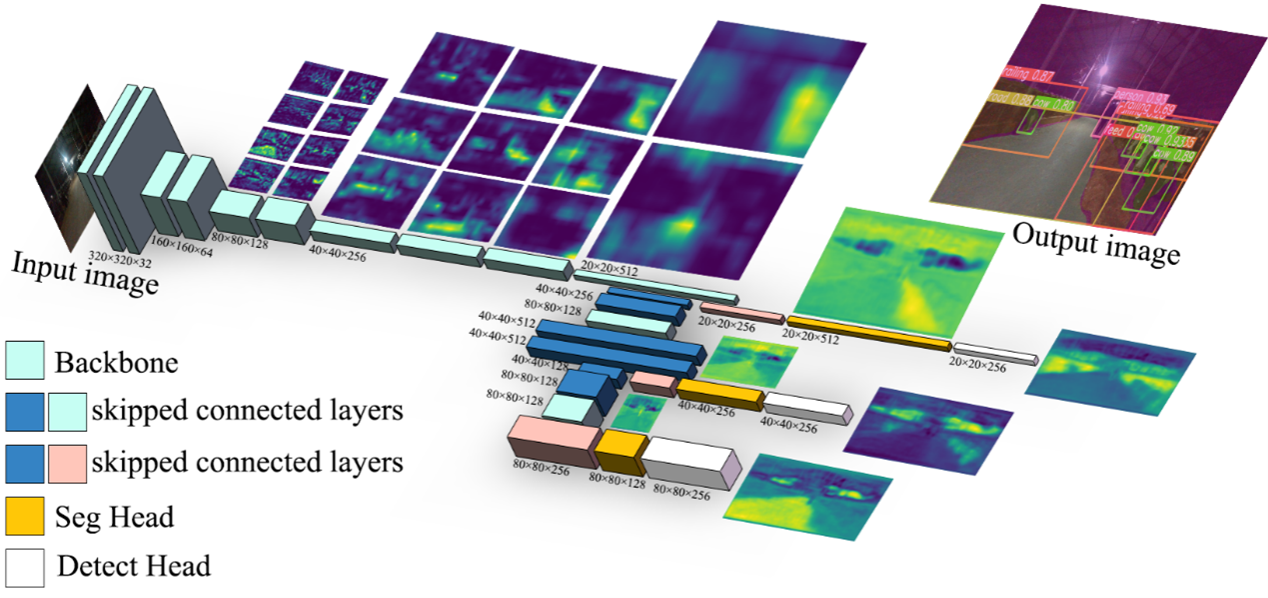

图1. 多任务牛舍目标识别与分割模型结构图

因此,本研究提出了一种基于多任务学习的牛场多类型目标识别与分割模型Ghost CBAM Segmentation-Multi-task (GCS-MUL)。首先,根据奶牛精准养殖需求,研制了奶牛饲料制备、布料、推料一体化机器人;第二,根据牛场目标的特点及机器人的工作特性,设计了牛场多目标识别模型,该模型融合CBAM模块,并采用自主设计的轻量化目标特征提取网络GCNet作为整个模型的骨干网络;第三,为提高模型多尺度特征融合水平,颈部网络利用了GhostConv和CSPGhost模块构建特征金字塔网络和路径聚合网络;最后,为实现牛场多目标实时语义分割目的,由特征融合、新型感受野和金字塔池化等模块共同融合构成分割头。试验结果表明,牛场目标的mAP@0.5达到94.86%;相较于YOLOv5模型,准确率和召回率分别提升7.47%和6.85%,相较于YOLOv7目标检测模型,准确率提升了5.1%;相较于SSD模型,模型大小减少了92.43%,平均检测时间提升了84.37 ms,满足了实时目标识别的要求;平均检测时间为66.43 ms,更适合配置于嵌入式设备;相较于不引入分割头的网络,准确率、召回率和mAP@0.5分别提升了4.49%、4.92%和6.58%。该研究成果能够为推料机器人牛场目标实时高效识别提供精确的算法,为自主行走提供更加有效的道路和环境场景分割方法。

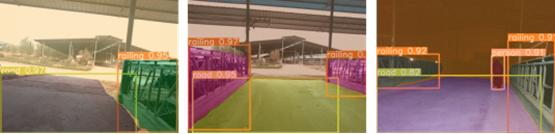

(a) 牛舍内检测结果

(b) 牛舍出口检测结果

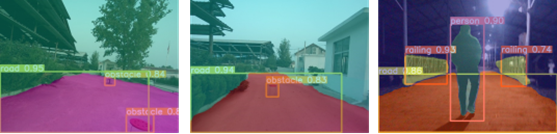

(c) 牛舍外检测结果

利用该模型轻量级的特点,将其配置在嵌入式人工智能计算机中,可实现的牛场白天和夜间的目标识别与分割。该研究为推料机器人牛场目标实时高效识别提供精确的算法,为农业机器人避障和自主路径提取的进一步研究提供了技术支持。

该研究得到了国家自然科学基金的资助。

论文链接:https://doi.org/10.1016/j.compag.2023.108000

编 辑:万 千

审 核:贾 波